AI智能摘要

当全球最大参数的开源代码模型 Qwen3-Coder 今日开源,你的IDE里即将多出一个能一次读懂百万行代码、与Claude Sonnet4正面硬刚的“AI同事”。480B MoE、256K上下文、附赠命令行神器Qwen Code,魔搭/HuggingFace已可下载,通义灵码即刻接入——错过它,等于错过下一代编程方式。

— 此摘要由AI分析文章内容生成,仅供参考。

DoNews7月23日消息,阿里云通义团队今日发布公告,宣布 Qwen3-Coder 正式开源,号称是“面向世界的智能编程引擎”。

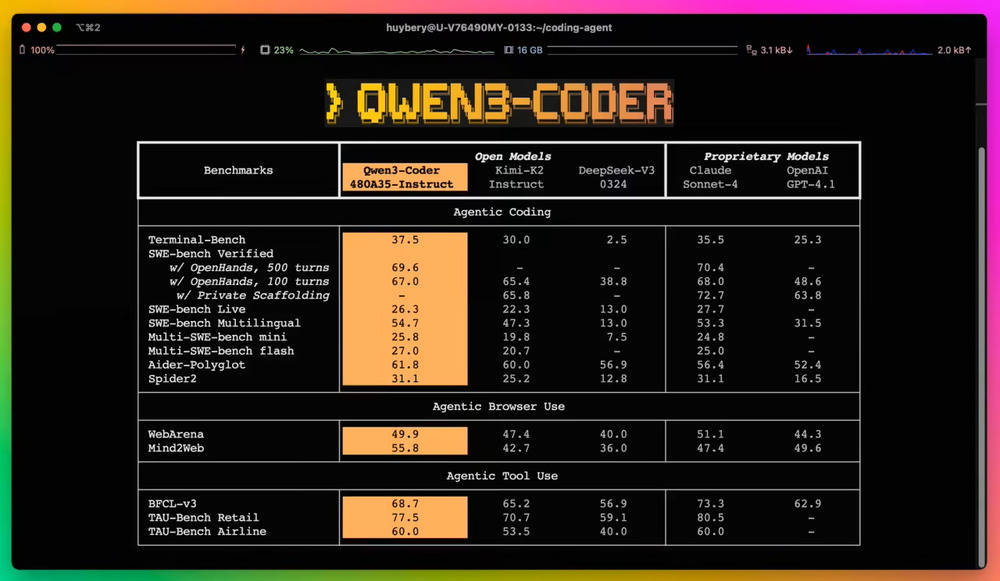

这也是该团队迄今为止最具 Agent 能力的代码模型,在 Agentic Coding、Agentic Browser-Use 和 Foundational Coding Tasks 上均取得了开源模型的 SOTA 效果,可以与 Claude Sonnet4 媲美。

据介绍,Qwen3-Coder 拥有多个尺寸,今天率先开源当前最强大版本:Qwen3-Coder-480B-A35B-Instruct 模型。

它是一个 MoE 模型,拥有 480B 参数,激活 35B 参数,原生支持 256K 上下文,并可通过 YaRN 扩展到 1M 长度,拥有卓越的代码和 Agent 能力。

为方便开发者更好地使用 Qwen3-Coder,阿里云通义团队还开源了一款命令行工具 Qwen Code,可充分发挥 Qwen3-Coder 在代理式编程上的潜力。此外,Qwen3-Coder 的 API 也可以和 Claude Code、Cline 等工具协同使用。

目前 Qwen3-Coder 已在魔搭社区、HuggingFace 等平台开源,后续很快将接入阿里的 AI 编程产品通义灵码,API 也已上线阿里云百炼。

有人试过改祖传屎山吗?256K上下文真能救我?

不懂就问,这玩意儿能帮我写前端屎山代码吗?

刚把stable-diffusion模型删了腾空间,现在又要下这个?

MoE架构确实省算力,但硬盘双倍伤害啊

已经有人在HuggingFace传量化版了,蹲

通义团队这是要逼死其他闭源模型吗?太卷了